Menschen mögen Roboter, die nicht zu perfekt sind

Soziale Roboter, die gelegentlich einen kleinen Fehler machen, sind den Menschen signifikant sympathischer als perfekte Roboter. Das ist ein Ergebnis der Forschungen eines Teams um die Nachwuchswissenschaftlerin Nicole Mirnig vom Center for Human-Computer Interaction der Universität Salzburg. Die Studie zu dieser Forschung, die unter dem Titel „To Err Is Robot“ erschienen ist, hat weltweit enormes Medieninteresse ausgelöst, von Australien, China, Russland bis zum Wall Street Journal in den USA.

Ein Forschungsziel der Salzburger Wissenschaftler ist es, soziale Roboter zur Kommunikation über ihre Fehler zu befähigen und so die Mensch-Roboter Interaktion weiter zu verbessern.

Das neue Zauberwort in der Robotik heißt „soziale Robotik“. Anders als Industrieroboter, die als reine Werkzeuge dienen, sollen soziale Roboter als freundliche Gefährten des Menschen fungieren. Sie können zum Beispiel Kinder beim Spracherwerb unterstützen oder alten Menschen im Haushalt helfen. Auch in Bereichen wie der Industrie oder bei autonomen Fahrzeugen gewinnen soziale Roboter durch zunehmende Kollaboration an Bedeutung. Wie aber reagieren Menschen, wenn soziale Roboter Fehler machen? Bisher wurde das kaum gezielt untersucht.

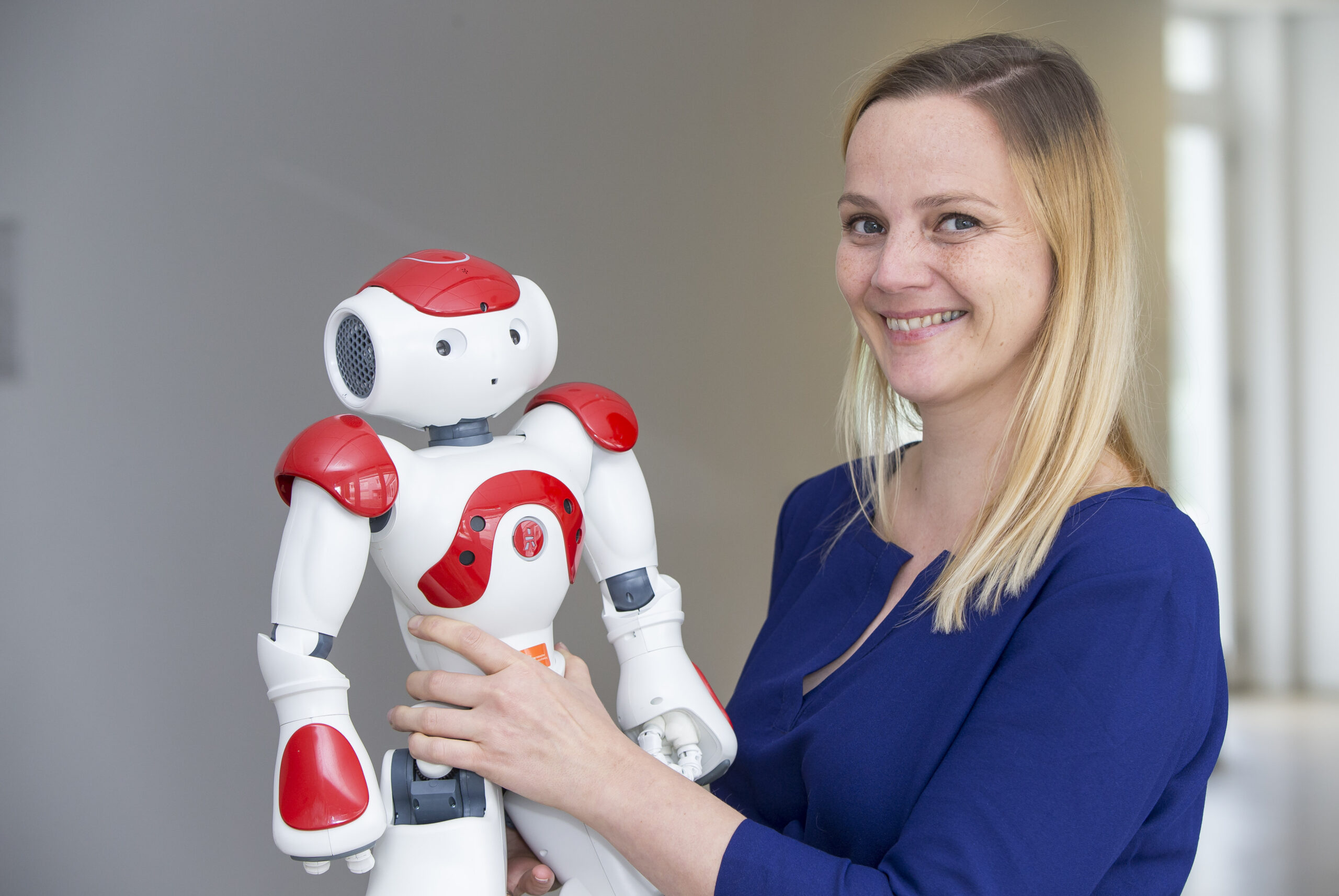

Nun hat die Kommunikationswissenschaftlerin Nicole Mirnig mit einem Team von Informatikern und Kommunikationswissenschaftlerinnen am Center for Human-Computer Interaction (HCI) der Universität Salzburg dazu eine Laborstudie durchgeführt. Das Center for HCI, das von Professor Manfred Tscheligi geleitet wird, widmet sich unter anderem der sozialen Interaktion zwischen Mensch und Roboter, mit dem Ziel die Schnittstelle so zu verbessern, dass die Interaktion für die Menschen angenehmer, verständlicher und effizienter wird.

„Ein Kernergebnis unserer Studie ist, dass Menschen einen Roboter, der nicht ganz so perfekt ist, liebenswürdiger finden als einen perfekten“, resümiert Nicole Mirnig.

Und so war die Studie aufgebaut: Die Wissenschaftler ließen 45 Testpersonen mit dem humanoiden (menschenähnlichen) Roboter NAO interagieren. Der knapp 60 cm große, 5 kg schwere, sprechende Roboter zählt zu den leistungsfähigsten Humanoiden. „Wir haben NAO so programmiert, dass bei der einen Hälfte der Testpersonen alles glatt lief, bei der anderen Hälfte machte er zwischendurch kleine Fehler. Er ließ zum Beispiel bei einer LEGO-Aufgabe, in der die Probanden ihm einen Stein in die Hand geben sollten, diesen fallen.“ Zudem blieb er einmal in einer Wortschleife hängen („Gib mir den gelben, gelben, gelben …“) Außer den kleinen technischen Fehlern beging er auch soziale Normverstöße, indem er zum Beispiel die Testpersonen aufforderte, LEGO-Steine auf den Boden zu werfen.

Alle Probanden erkannten, dass es sich um Fehler handelte, aber keinen hat es wirklich gestört. Sie schätzten den Roboter deswegen nicht als dümmer oder menschlicher ein, aber sie mochten ihn wesentlich lieber als die Kontrollgruppe den perfekten Robo-Guide.

Woran das liegt, lasse sich – so Nicole Mirnig – mit dem sogenannten Pratfall Effekt erklären. „Der Pratfall Effekt besagt, dass die Attraktivität einer als sehr kompetent eingeschätzten Person steigt, wenn ihr ein kleines Missgeschick widerfährt. Wenn jemand zu perfekt ist, erscheint er einem weit weg von einem selbst und man findet ihn daher weniger sympathisch. Dieses sozialpsychologische Phänomen haben Wissenschaftler um den renommierten US Psychologen Elliot Aronson erstmals im Jahr 1966 beschrieben. Mit unserer Studie konnten wir zeigen, dass der Pratfall Effekt, der sich auf zwischenmenschliche Interaktionen bezieht, in gleicher Weise auch auf die Mensch-Roboter Interaktion zutrifft: Wer mit einem Roboter zu tun hat, der Fehler macht, fühlt sich ihm nicht so unterlegen und mag ihn daher lieber.“

Die neuesten Daten aus der Laborstudie werden gestützt durch eine große Menge von Realdaten-Analysen, die die Salzburger Wissenschaftler und Wissenschaftlerinnen davor schon durchgeführt und auch publiziert hatten. Dabei handelte es sich eine Art Randforschung, die sich als Datenrest aus diversen Projekten insofern ergeben hatte, als die Roboter im Feld während anderer Studien oft unbeabsichtigt Fehler gemacht hatten. „Meines Wissens ist unsere Arbeit die erste Studie zu Fehlersituationen die auf einem großen Korpus an Realdaten aufbaut. Zum Beispiel hatten wir Daten von einem Projekt der TU München, in dem wir als Projektpartner fungierten.

In diesem Projekt ist der Navigationsroboter IURO autonom durch die Münchner Innenstadt gefahren und hat Passanten nach dem Weg gefragt. Dank unseres Mitarbeiters Manuel Giuliani hatten wir noch mehr Daten als unsere eigenen, zum Beispiel welche vom Barroboter James, der in München Getränke ausgeschenkt hat. Wir hatten ungefähr zweihundert Videos aus Realsituationen analysiert. In unserer Laborstudie haben wir dann konkrete Fehlersituationen repliziert. Das macht unsere Studie sehr lebensnah.“

Die Medienresonanz auf die Studie „To Err Is Robot“, die im Mai 2017 im online Fachjournal „Frontiers in Robotics and AI“ publiziert wurde, war außergewöhnlich groß und sehr international. Sie reichte von ABC Radio Melbourne/Australien bis zum Wall Street Journal/USA, das ein Interview mit Nicole Mirnig führte. Es gab chinesische, koreanische und russische Beiträge, aber auch das deutsche Wissenschaftsmagazin „Bild der Wissenschaft“ (Oktober-Ausgabe) berichtete zum Beispiel darüber.

Und was ist für Nicole Mirnig das langfristige Ziel ihrer Forschung? „Wir möchten die Mensch-Roboter Interaktion insofern verbessern, als dass der Roboter an den Reaktionen der Menschen erkennt, dass er einen Fehler gemacht hat und sich dann an der Fehlerbehebung aktiv beteiligt. Menschen lachen, reden mehr, schauen mehr herum und bewegen den Kopf stärker, wenn ein Roboter Fehler macht, haben wir festgestellt. Diese Daten könnte man dem Roboter zur Verfügung stellen, damit er mögliche Lösungen anbietet.“

Publikation: Nicole Mirnig, Gerald Stollnberger, Markus Miksch, Susanne Stadler, Manuel Giuliani and Manfred Tscheligi: To Err Is Robot. How Humans Assess and Act towards an Erroneous Social Robot. In: Frontiers in Robotics and AI, published: 31 May 2017

Kontakt: